In questo post, desidero condividere con voi il mio progetto sulla scoperta di “Stable Diffusion”.

Introduzione

Stable Diffusion è un modello di intelligenza artificiale avanzato progettato per la generazione e la trasformazione di immagini. Si basa su tecniche di deep learning per elaborare e modificare le immagini in modo creativo e realistico. Inizialmente progettato per generare immagini a partire da descrizioni testuali, Stable Diffusion è evoluto per accettare anche immagini in ingresso. Questa capacità rende Stable Diffusion particolarmente utile per applicazioni quali il fotoritocco, la creazione artistica assistita da IA e il miglioramento della qualità delle immagini.

A proposito del Progetto

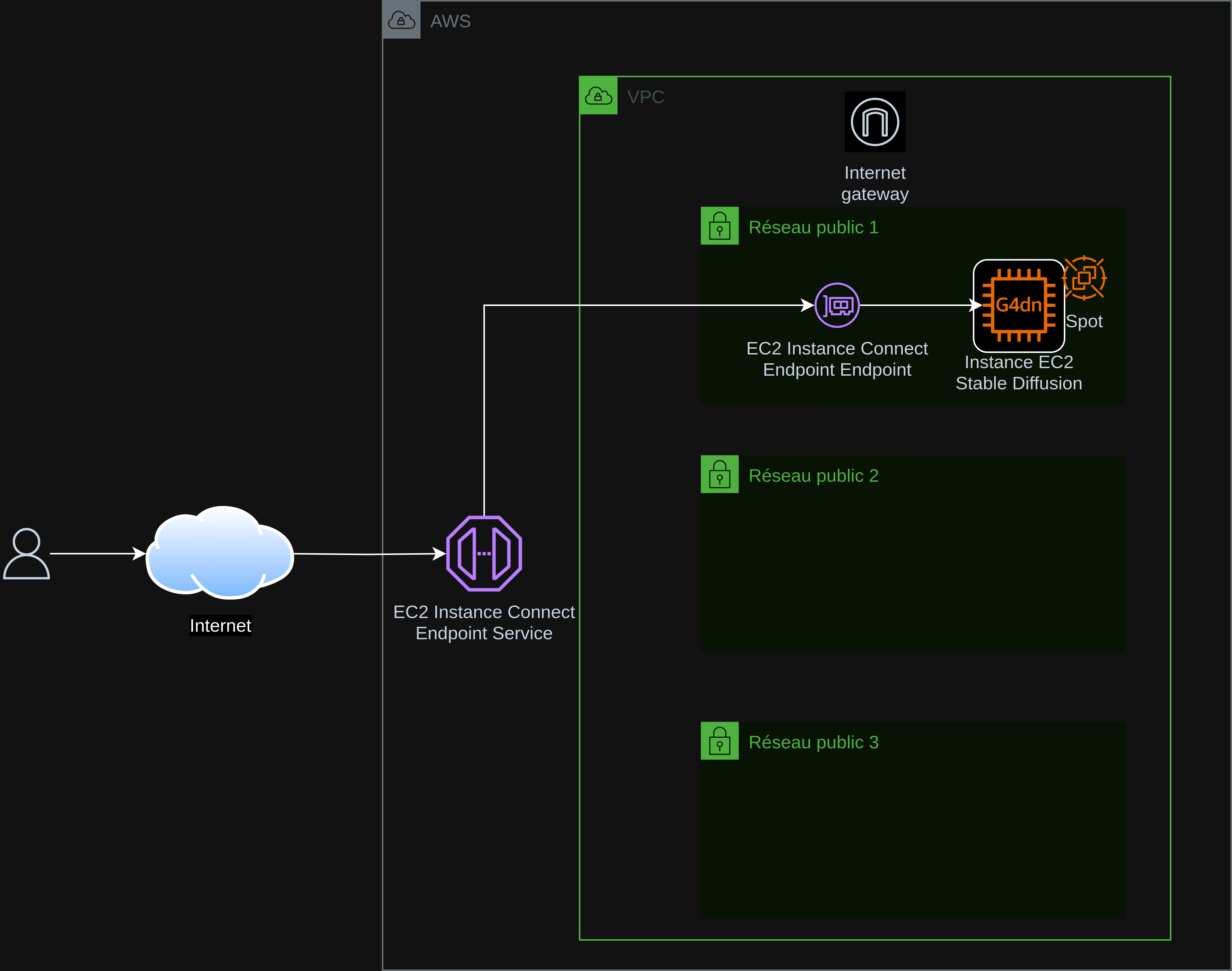

Questo progetto permette di distribuire facilmente “Stable Diffusion XL con Controlnet” nel cloud AWS su un’EC2.

Automatizza la creazione e la configurazione dell’infrastruttura necessaria per eseguire “Stable Diffusion XL con Controlnet”.

L’installazione di Stable Diffusion viene eseguita manualmente una volta disponibile l’EC2 (con una guida da copiare/incollare).

Per limitare i costi EC2 viene utilizzata un’istanza spot di tipo g4dn.xlarge (1 GPU NVIDIA T4 16 GB GDDR6, 4 vCPU Intel Cascade Lake, 16 GB RAM).

Il deployment di Stable Diffusion è effettuato con l’installer AUTOMATIC1111.

Architettura

Obiettivi del Progetto

- Generazione d’immagine: Generare immagini di alta qualità da un prompt.

- Accessibilità: Rendere queste tecnologie accessibili e comprensibili.

- Collaborazione aperta: Incoraggiare la collaborazione e la condivisione delle conoscenze.

> > > > > > > > > > Visita il mio progetto su GitLab cliccando qui < < < < < < < < < <

Questo documento è stato tradotto dalla versione fr alla lingua it utilizzando il modello gpt-4o. Per ulteriori informazioni sul processo di traduzione, consultare https://gitlab.com/jls42/ai-powered-markdown-translator.