W tym poście chciałbym podzielić się z wami moim projektem odkrycia “Stable Diffusion”.

Wprowadzenie

Stable Diffusion to zaawansowany model sztucznej inteligencji zaprojektowany do generowania i przekształcania obrazów. Wykorzystuje on techniki głębokiego uczenia się do kreatywnego i realistycznego przetwarzania i modyfikacji obrazów. Początkowo zaprojektowany do generowania obrazów na podstawie opisów tekstowych, Stable Diffusion ewoluował, aby akceptować również obrazy jako dane wejściowe. Ta zdolność sprawia, że Stable Diffusion jest szczególnie przydatny w aplikacjach takich jak retusz zdjęć, sztuka wspomagana przez AI i poprawa jakości obrazów.

O Projekcie

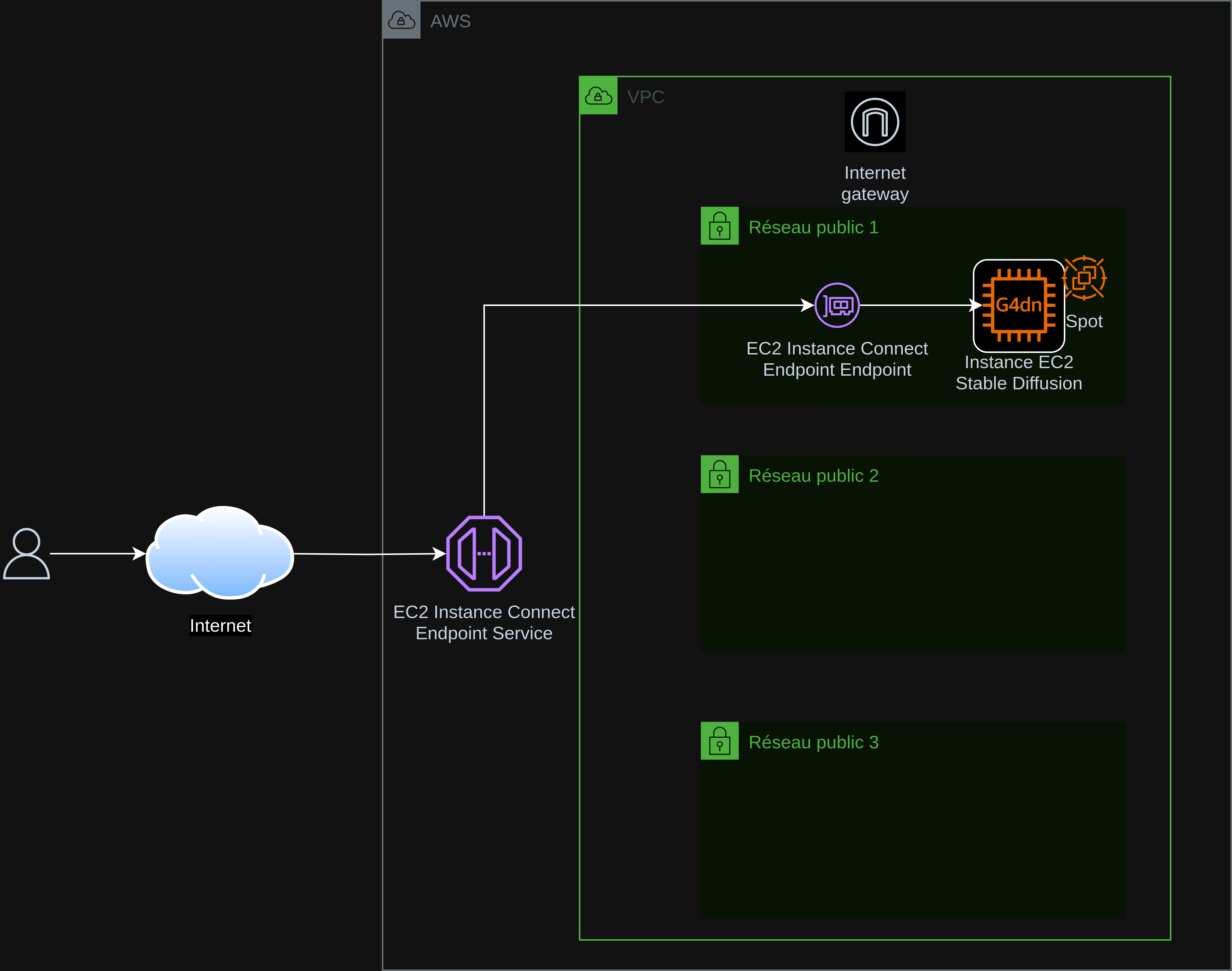

Ten projekt umożliwia łatwe wdrażanie “Stable Diffusion XL z Controlnet” w chmurze AWS na EC2.

Automatyzuje on tworzenie i konfigurację infrastruktury potrzebnej do uruchomienia “Stable Diffusion XL z Controlnet”.

Instalacja Stable Diffusion jest przeprowadzana ręcznie po udostępnieniu EC2 (z przewodnikiem do skopiowania i wklejenia).

Aby ograniczyć koszty EC2, wykorzystywana jest instancja spotowa typu g4dn.xlarge (1 GPU NVIDIA T4 16 GB GDDR6, 4 vCPU Intel Cascade Lake, 16 GB RAM).

Wdrażanie Stable Diffusion jest realizowane za pomocą instalatora AUTOMATIC1111.

Architektura

Cele Projektu

- Generowanie obrazów : Generowanie wysokiej jakości obrazów na podstawie promptu.

- Dostępność : Uczynienie tych technologii dostępnymi i zrozumiałymi.

- Otwarta współpraca : Zachęcanie do współpracy i dzielenia się wiedzą.

> > > > > > > > > > Odwiedź mój projekt na GitLab klikając tutaj < < < < < < < < < <

Ten dokument został przetłumaczony z wersji fr na język pl przy użyciu modelu gpt-4o. Aby uzyskać więcej informacji na temat procesu tłumaczenia, odwiedź https://gitlab.com/jls42/ai-powered-markdown-translator