Ich freue mich, mein neuestes Projekt vorzustellen: die vollständig automatisierte Bereitstellung von LibreChat auf AWS EC2, ein Open-Source-Ansatz, verfügbar auf GitLab. Dieses Projekt demonstriert mein Können in DevOps und Cloud Engineering, basierend auf Terraform für Infrastructure as Code (IaC), einem Bash-User-Data-Skript, einer GitLab CI/CD-Pipeline und einer zentralisierten Verwaltung über AWS Systems Manager (SSM). Ergebnis: eine betriebsbereite LibreChat-Instanz in weniger als 6 Minuten, mit optimierten Kosten, erhöhter Sicherheit und maximaler Erreichbarkeit.

Dieses Projekt geht über eine rein technische Bereitstellung hinaus: es steht für fortgeschrittene Automatisierung, gedacht für Experten und Einsteiger gleichermaßen. So habe ich die Lösung konzipiert.

1. Eine optimierte und reproduzierbare Cloud-Architektur

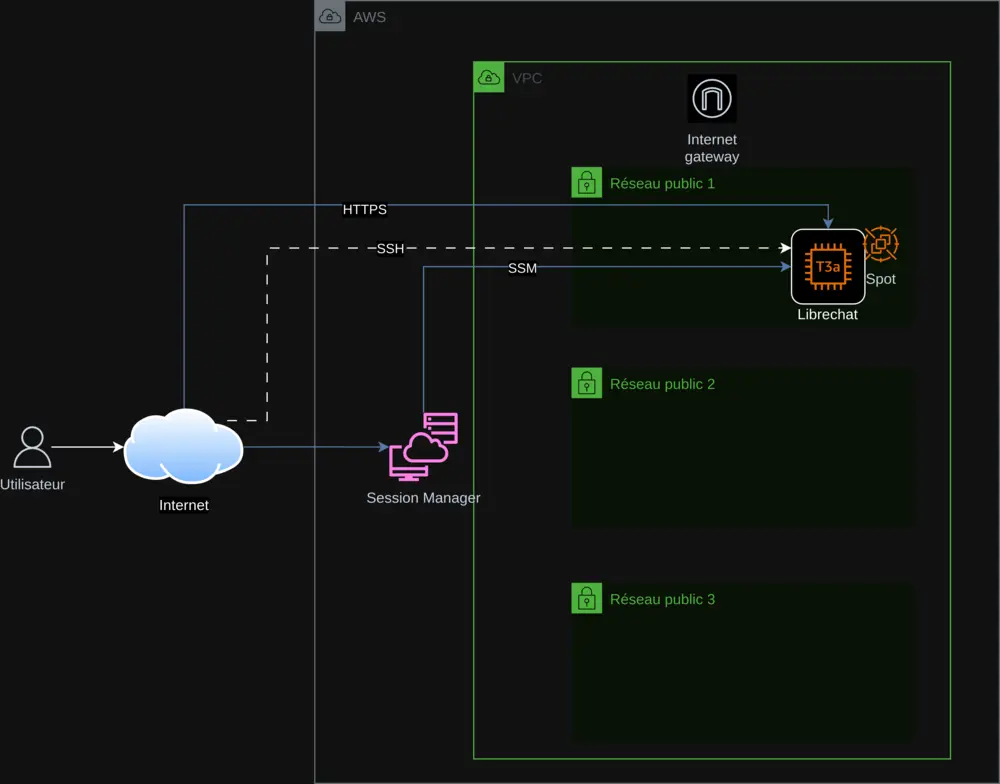

Die Infrastruktur basiert auf Terraform und folgt den Prinzipien von Infrastructure as Code für lückenlose Reproduzierbarkeit und Skalierbarkeit. Die Hauptkomponenten sind:

- AWS VPC: Ein isoliertes virtuelles Netzwerk zur Absicherung der Infrastruktur.

- Öffentliche Subnetze: Drei Subnets zur Gewährleistung hoher Verfügbarkeit.

- EC2-Instanz (t3a.small): Hält LibreChat bereit, mit der Option zwischen Spot Instances oder On-Demand.

- Internet Gateway: Ermöglicht sichere Verbindungen via HTTPS.

- AWS SSM: Zentralisiert die Verwaltung der API-Schlüssel und das Deployment-Tracking.

Die Bereitstellung auf EC2 ist automatisiert durch ein Bash-User-Data-Skript, das:

- Abhängigkeiten (Docker, Git, Node.js) installiert und das System aktualisiert.

- LibreChat (Version 0.7.7) clont und die Dateien

.envundlibrechat.yamlkonfiguriert. - API-Schlüssel sicher aus SSM abruft.

- Nginx mit einem selbstsignierten SSL-Zertifikat für HTTPS konfiguriert.

Dieses Skript, integriert via Terraform, enthält Fehlerbehandlung (set -e, trap 'error_handler' ERR) und Logging in /var/log/user-data.log, was einen zuverlässigen und nachverfolgbaren Prozess sicherstellt.

2. Sicherheit und zentrale Verwaltung der API-Schlüssel

Sicherheit hat Priorität. Die API-Schlüssel (OpenAI, Mistral AI, Anthropic, Google) werden im AWS SSM Parameter Store gespeichert, dynamisch abgerufen und niemals hartkodiert. Maßnahmen umfassen:

- HTTPS verpflichtend: Selbstsigniertes Zertifikat mit Weiterleitung von Port 80 auf 443.

- Fehlerbehandlung: Abbruch des Skripts bei Problemen mit Statusaktualisierung in SSM.

- AWS Session Manager: Zugriff auf die Instanz ohne SSH für erhöhte Sicherheit.

Dieser Ansatz gewährleistet sichere Verwaltung und Echtzeit-Überwachung.

3. Kostenoptimierung mit Spot Instances

Zur Kostensenkung habe ich AWS Spot Instances integriert, um ungenutzte Kapazitäten zu nutzen. Eine Terraform-Variable spot_enabled erlaubt die Wahl zwischen Spot und On-Demand, womit das Projekt für verschiedene Einsatzzwecke zugänglich bleibt. Ein Python-Skript, check_spot.py, passt automatisch die Preise in variables.tf zur kontinuierlichen Optimierung an.

4. Eine vollständige CI/CD-Pipeline mit GitLab

Eine GitLab CI/CD-Pipeline (definiert in gitlab-ci.yml) orchestriert die Bereitstellung:

- Terraform: Plant und wendet Infrastrukturänderungen an.

- Instanzverwaltung: Startet, stoppt und prüft den Zustand via SSM.

- API-Schlüssel: Fügt Keys sicher hinzu oder entfernt sie.

- Registrierungen: Kontrolliert die Zugriffe auf LibreChat.

Das Skript export.sh vereinfacht die Befehle, sowohl lokal als auch über CI/CD, und bietet ein flüssiges, professionelles Erlebnis.

5. Globale Erreichbarkeit durch Internationalisierung

Um ein weltweites Publikum zu erreichen, ist das README in sechs Sprachen übersetzt (Englisch, Deutsch, Spanisch, Japanisch, Koreanisch, Chinesisch) mithilfe meines KI-Übersetzer-Skripts. Dadurch ist das Projekt inklusiv und für alle Nutzer zugänglich.

6. Technische Herausforderungen erfolgreich gemeistert

Die Anpassung von LibreChat 0.7.6 erforderte präzise Anpassungen:

- Mistral-Support: Aktualisierung von

librechat.yamlfürmistral-large-latest. - Nginx: Korrektur der SSL-Direktiven für HTTP/2.

- Spot/On-Demand: Flexible Steuerung via Terraform.

Diese Herausforderungen wurden durch gründliche Tests und ausführliche Dokumentation gemeistert.

7. Warum dieses Projekt hervorsticht

Dieses Projekt zeichnet sich aus durch:

- Vollständige Automatisierung: Alles ist skriptgesteuert, von der Infrastruktur bis zur Installation.

- Optimierung: Reduzierte Kosten und verbesserte Performance.

- Sicherheit: Zentrale Verwaltung und HTTPS per Default.

- Zugänglichkeit: Mehrsprachige Dokumentation und einfache Optionen.

Es spiegelt meine Fähigkeiten in AWS-Architektur, DevOps, Cloud und Scripting wider, sowie meine Leidenschaft für Open Source.

Entdecken und Mitmachen!

Erkunde dieses Projekt auf GitLab, teste es und gib Feedback. Ob Experte oder Anfänger — dieses Projekt ist für dich. Trage zur Weiterentwicklung bei!

Kontakt : contact@jls42.org

Über mich : Ich bin Julien LS, leidenschaftlich in AWS-Cloud-Architektur, DevOps, KI und Automatisierung. Dieses Projekt reiht sich ein in meine Arbeiten wie BabelFish AI. Finde mich auf GitLab.

Dieses Dokument wurde von der fr-Version in die Sprache en mithilfe des Modells gpt-5-mini übersetzt. Für weitere Informationen zum Übersetzungsprozess konsultieren Sie https://gitlab.com/jls42/ai-powered-markdown-translator