Tenho o prazer de apresentar meu último projeto: o implantação totalmente automatizada do LibreChat na AWS EC2, uma solução open-source disponível no GitLab. Este projeto demonstra minha experiência em DevOps e engenharia de nuvem, apoiando-se em Terraform para infraestrutura como código (IaC), um script User-Data em Bash, uma pipeline GitLab CI/CD e gerenciamento centralizado via AWS Systems Manager (SSM). Resultado: uma instância LibreChat operacional em menos de 6 minutos, com custos otimizados, segurança reforçada e máxima acessibilidade.

Este projeto vai além de um simples deployment técnico: incorpora uma visão de automação avançada, pensada para especialistas e iniciantes. Aqui está como concebi essa solução.

1. Uma Arquitetura de Nuvem Otimizada e Reproduzível

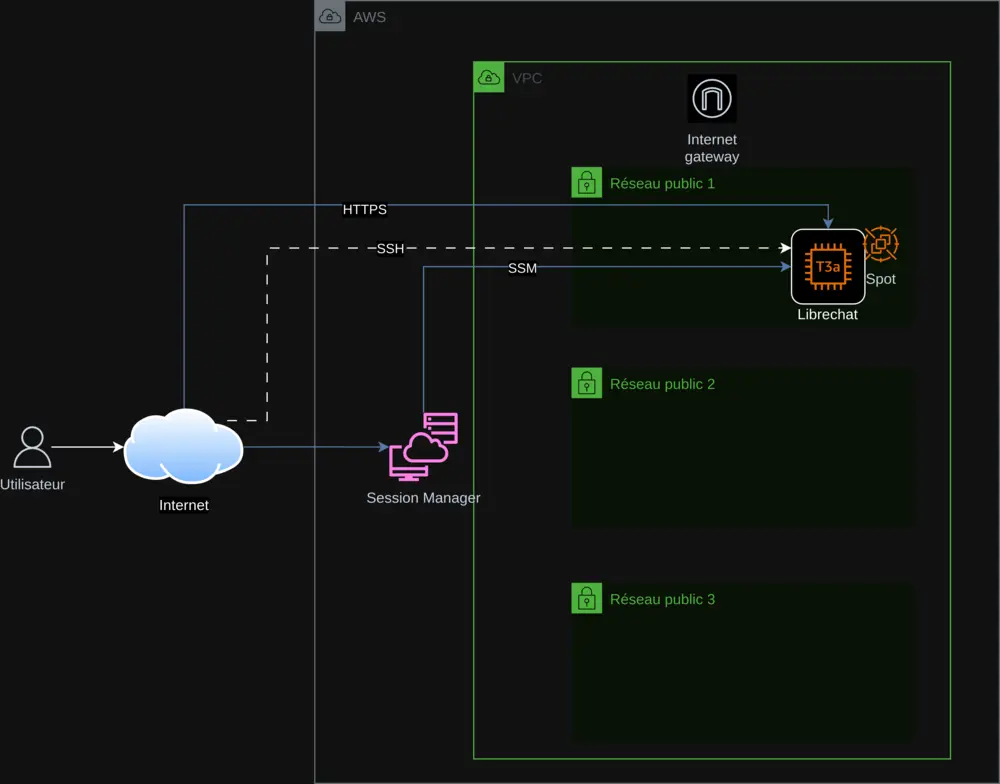

A infraestrutura baseia-se em Terraform, respeitando os princípios de Infrastructure as Code para reprodutibilidade e escalabilidade sem falhas. Os principais componentes incluem:

- AWS VPC: Uma rede virtual isolada para proteger a infraestrutura.

- Sub-redes públicas: Três subnets para garantir alta disponibilidade.

- Instância EC2 (t3a.small): Hospeda o LibreChat, com opção entre Instâncias Spot ou On-Demand.

- Internet Gateway: Permite conexão segura via HTTPS.

- AWS SSM: Centraliza o gerenciamento das chaves de API e o acompanhamento do deployment.

O deployment na EC2 é automatizado por meio de um script User-Data em Bash que:

- Instala as dependências (Docker, Git, Node.js) e atualiza o sistema.

- Clona o LibreChat (versão 0.7.7) e configura os arquivos

.envelibrechat.yaml. - Recupera as chaves de API do SSM de forma segura.

- Configura o Nginx com um certificado SSL autoassinado para HTTPS.

Esse script, integrado via Terraform, inclui tratamento de erros (set -e, trap 'error_handler' ERR) e logging em /var/log/user-data.log, garantindo um processo confiável e auditável.

2. Segurança e Gerenciamento Centralizado das Chaves de API

A segurança é uma prioridade. As chaves de API (OpenAI, Mistral AI, Anthropic, Google) são armazenadas no AWS SSM Parameter Store, recuperadas dinamicamente e nunca codificadas diretamente. As medidas incluem:

- HTTPS obrigatório: Certificado autoassinado com redirecionamento da porta 80 para 443.

- Tratamento de erros: Interrupção do script em caso de problema, com atualização de status no SSM.

- AWS Session Manager: Acesso à instância sem SSH para maior segurança.

Essa abordagem garante gerenciamento seguro e supervisão em tempo real.

3. Otimização de Custos com Instâncias Spot

Para reduzir custos, integrei as Instâncias Spot da AWS, aproveitando recursos ociosos. Uma variável Terraform spot_enabled permite escolher entre Spot e On-Demand, tornando o projeto acessível a todos. Um script Python, check_spot.py, ajusta automaticamente os preços em variables.tf para otimização contínua.

4. Uma Pipeline CI/CD Completa com GitLab

Uma pipeline GitLab CI/CD (definida em gitlab-ci.yml) orquestra o deployment:

- Terraform: Planeja e aplica as mudanças na infraestrutura.

- Gerenciamento das instâncias: Inicia, para e verifica o estado via SSM.

- Chaves de API: Adiciona ou remove chaves com segurança.

- Registros: Controla os acessos ao LibreChat.

O script export.sh simplifica os comandos, seja localmente ou via CI/CD, oferecendo uma experiência fluida e profissional.

5. Acessibilidade Global graças à Internacionalização

Para alcançar um público mundial, o README foi traduzido para seis idiomas (inglês, alemão, espanhol, japonês, coreano, chinês) graças ao meu script de tradução IA. Isso torna o projeto inclusivo e adequado para todos os usuários.

6. Desafios Técnicos Superados com Sucesso

Adaptar o LibreChat 0.7.6 exigiu ajustes precisos:

- Suporte ao Mistral: Atualização de

librechat.yamlparamistral-large-latest. - Nginx: Correção das diretivas SSL para HTTP/2.

- Spot/On-Demand: Gerenciamento flexível via Terraform.

Esses desafios foram superados com testes rigorosos e documentação detalhada.

7. Por que Este Projeto se Destaca

Este projeto diferencia-se por:

- Automação completa: Tudo é scriptado, da infra à instalação.

- Otimização: Custos reduzidos e desempenho aprimorado.

- Segurança: Gerenciamento centralizado e HTTPS por padrão.

- Acessibilidade: Documentação multilíngue e opções simples.

Reflete minhas competências em Arquitetura AWS, DevOps, nuvem e scripting, além da minha paixão pelo open-source.

Descubra e Participe!

Explore este projeto no GitLab, teste-o e compartilhe seu feedback. Seja você especialista ou iniciante, este projeto é para você. Contribua para fazê-lo crescer!

Contato: contact@jls42.org

Sobre mim: Sou Julien LS, entusiasta de arquitetura de nuvem AWS, DevOps, IA e automação. Este projeto está alinhado com meu trabalho como BabelFish AI. Encontre-me no GitLab.

Este documento foi traduzido da versão fr para a língua pt usando o modelo gpt-5-mini. Para mais informações sobre o processo de tradução, consulte https://gitlab.com/jls42/ai-powered-markdown-translator