Jag är glad att presentera mitt senaste projekt: den helt automatiserade driftsättningen av LibreChat på AWS EC2, en öppen källkodslösning tillgänglig på GitLab. Detta projekt demonstrerar min kompetens inom DevOps och cloud engineering, och bygger på Terraform för Infrastructure as Code (IaC), ett User-Data-script i Bash, en GitLab CI/CD-pipeline och centraliserad hantering via AWS Systems Manager (SSM). Resultatet: en fungerande LibreChat-instans på under 6 minuter, med optimerade kostnader, förbättrad säkerhet och maximal åtkomlighet.

Det här projektet är mer än en ren teknisk driftsättning: det representerar en vision för avancerad automatisering, avsedd för både experter och nybörjare. Så här har jag utformat lösningen.

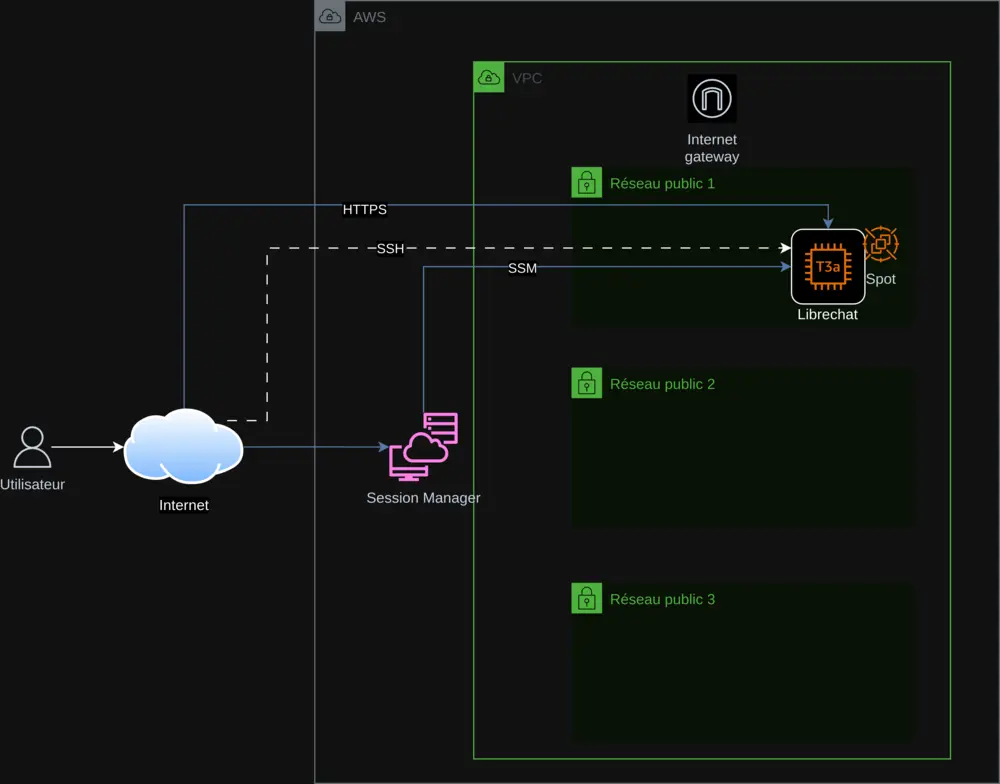

1. En optimerad och reproducerbar molnarkitektur

Infrastrukturen bygger på Terraform, enligt principerna för Infrastructure as Code för att säkerställa reproducerbarhet och skalbarhet. Huvudkomponenterna inkluderar:

- AWS VPC: Ett isolerat virtuellt nätverk för att säkra infrastrukturen.

- Publika subnät: Tre subnät för att garantera hög tillgänglighet.

- EC2-instans (t3a.small): Värdar LibreChat, med val mellan Spot Instances eller On-Demand.

- Internet Gateway: Möjliggör säker anslutning via HTTPS.

- AWS SSM: Centraliserar hantering av API-nycklar och övervakning av driftsättningen.

Driftsättningen på EC2 automatiseras med ett User-Data-script i Bash som:

- Installerar beroenden (Docker, Git, Node.js) och uppdaterar systemet.

- Klonar LibreChat (version 0.7.7) och konfigurerar filerna

.envochlibrechat.yaml. - Hämtar API-nycklar från SSM på ett säkert sätt.

- Konfigurerar Nginx med ett självsignerat SSL-certifikat för HTTPS.

Detta script, integrerat via Terraform, innehåller felhantering (set -e, trap 'error_handler' ERR) och loggning i /var/log/user-data.log, vilket säkerställer en pålitlig och spårbar process.

2. Säkerhet och centraliserad hantering av API-nycklar

Säkerhet är en prioritet. API-nycklar (OpenAI, Mistral AI, Anthropic, Google) lagras i AWS SSM Parameter Store, hämtas dynamiskt och hårdkodas aldrig. Åtgärderna inkluderar:

- HTTPS obligatoriskt: Självsignerat certifikat med omdirigering från 80 till 443.

- Felhantering: Scriptet avslutas vid problem, med uppdatering av status i SSM.

- AWS Session Manager: Åtkomst till instansen utan SSH för förbättrad säkerhet.

Denna metod garanterar säker hantering och realtidsövervakning.

3. Kostnadsoptimering med Spot Instances

För att minska kostnaderna har jag integrerat Spot Instances i AWS för att utnyttja outnyttjade resurser. En Terraform-variabel spot_enabled tillåter val mellan Spot och On-Demand, vilket gör projektet tillgängligt för alla. Ett Python-script, check_spot.py, justerar automatiskt priserna i variables.tf för kontinuerlig optimering.

4. En komplett CI/CD-pipeline med GitLab

En GitLab CI/CD-pipeline (definierad i gitlab-ci.yml) orkestrerar driftsättningen:

- Terraform: Planerar och applicerar infrastrukturella förändringar.

- Hantering av instanser: Startar, stoppar och kontrollerar status via SSM.

- API-nycklar: Lägger till eller tar bort nycklar på ett säkert sätt.

- Registreringar: Kontrollerar åtkomster till LibreChat.

Scriptet export.sh förenklar kommandona, både lokalt och via CI/CD, och erbjuder en smidig och professionell upplevelse.

5. Global åtkomlighet tack vare internationalisering

För att nå en global publik är README översatt till sex språk (engelska, tyska, spanska, japanska, koreanska, kinesiska) med hjälp av mitt AI-översättningsskript. Detta gör projektet inkluderande och tillgängligt för flera användare.

6. Tekniska utmaningar som framgångsrikt lösts

Att anpassa LibreChat 0.7.6 krävde noggranna justeringar:

- Mistral-stöd: Uppdatering av

librechat.yamlförmistral-large-latest. - Nginx: Korrigering av SSL-direktiv för HTTP/2.

- Spot/On-Demand: Flexibel hantering via Terraform.

Dessa utmaningar övervanns med rigorösa tester och detaljerad dokumentation.

7. Varför detta projekt sticker ut

Detta projekt särskiljer sig genom:

- Fullständig automatisering: Allt är skrivet i script, från infra till installation.

- Optimering: Lägre kostnader och förbättrad prestanda.

- Säkerhet: Centraliserad hantering och HTTPS som standard.

- Åtkomlighet: Flerspråkig dokumentation och enkla alternativ.

Det speglar mina färdigheter inom AWS-arkitektur, DevOps, moln och scripting, samt min passion för öppen källkod.

Upptäck och bidra!

Utforska projektet på GitLab, testa det och dela dina synpunkter. Oavsett om du är expert eller nybörjare är detta projekt för dig. Bidra gärna för att låta det växa!

Contact : contact@jls42.org

Om mig : Jag är Julien LS, passionerad om AWS-molnarkitektur, DevOps, AI och automatisering. Detta projekt är i linje med mina tidigare arbeten som BabelFish AI. Hitta mig på GitLab.

Detta dokument har översatts från fr-versionen till sv-språket med hjälp av modellen gpt-5-mini. För mer information om översättningsprocessen, se https://gitlab.com/jls42/ai-powered-markdown-translator