Sono lieto di presentarvi il mio ultimo progetto: il deploy completamente automatizzato di LibreChat su AWS EC2, una soluzione open-source disponibile su GitLab. Questo progetto illustra le mie competenze in DevOps e cloud engineering, basandosi su Terraform per l’infrastructure as code (IaC), uno script User-Data in Bash, una pipeline GitLab CI/CD e una gestione centralizzata tramite AWS Systems Manager (SSM). Risultato: un’istanza LibreChat operativa in meno di 6 minuti, con costi ottimizzati, maggiore sicurezza e massima accessibilità.

Questo progetto va oltre un semplice deploy tecnico: incarna una visione di automazione avanzata, pensata sia per esperti che per principianti. Ecco come ho progettato questa soluzione.

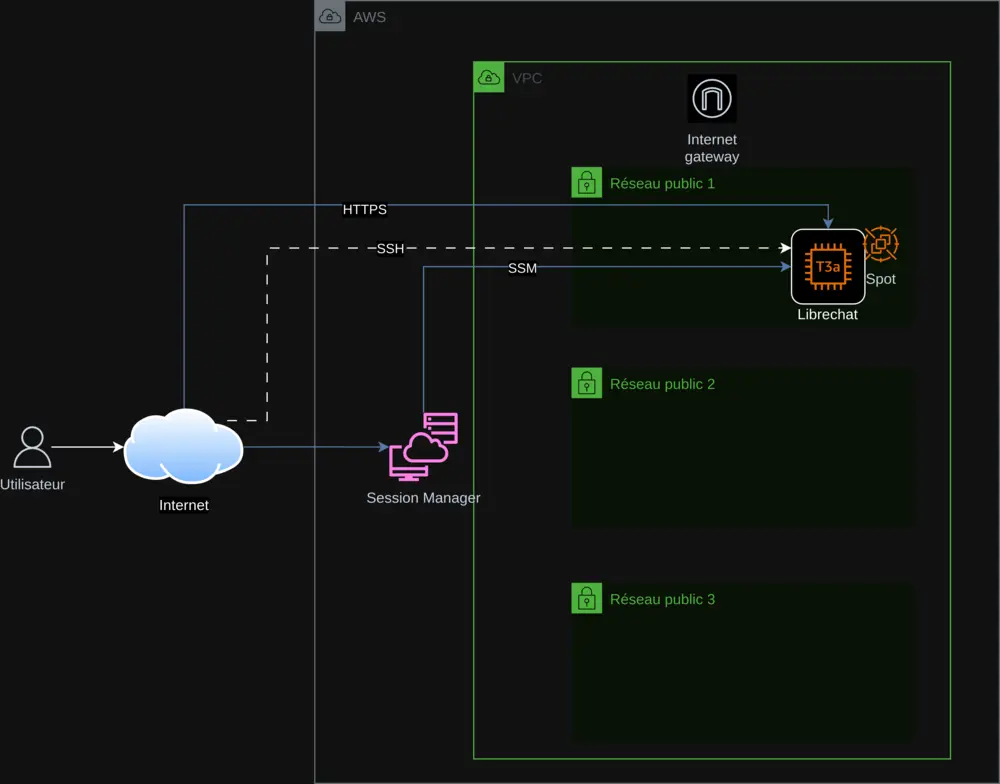

1. Un’architettura cloud ottimizzata e riproducibile

L’infrastruttura si basa su Terraform, rispettando i principi dell’Infrastructure as Code per garantire riproducibilità e scalabilità senza interruzioni. I componenti principali includono:

- AWS VPC: Una rete virtuale isolata per mettere in sicurezza l’infrastruttura.

- Sottoreti pubbliche: Tre subnet per garantire alta disponibilità.

- Istanza EC2 (t3a.small): Ospita LibreChat, con la possibilità di scegliere tra Spot Instances o On-Demand.

- Internet Gateway: Consente una connessione sicura tramite HTTPS.

- AWS SSM: Centralizza la gestione delle chiavi API e il monitoraggio del deployment.

Il deploy su EC2 è automatizzato tramite uno script User-Data in Bash che:

- Installa le dipendenze (Docker, Git, Node.js) e aggiorna il sistema.

- Clona LibreChat (versione 0.7.7) e configura i file

.envelibrechat.yaml. - Recupera le chiavi API da SSM in modo sicuro.

- Configura Nginx con un certificato SSL auto-firmato per HTTPS.

Questo script, integrato tramite Terraform, include la gestione degli errori (set -e, trap 'error_handler' ERR) e una registrazione dei log in /var/log/user-data.log, assicurando un processo affidabile e tracciabile.

2. Sicurezza e gestione centralizzata delle chiavi API

La sicurezza è una priorità. Le chiavi API (OpenAI, Mistral AI, Anthropic, Google) sono memorizzate in AWS SSM Parameter Store, recuperate dinamicamente e mai inserite in chiaro. Le misure comprendono:

- HTTPS obbligatorio: Certificato auto-firmato con reindirizzamento dalla porta 80 alla 443.

- Gestione degli errori: Arresto dello script in caso di problemi, con aggiornamento dello stato in SSM.

- AWS Session Manager: Accesso all’istanza senza SSH per una maggiore sicurezza.

Questo approccio garantisce una gestione sicura e un controllo in tempo reale.

3. Ottimizzazione dei costi con le Spot Instances

Per ridurre i costi ho integrato le Spot Instances di AWS, sfruttando risorse inutilizzate. Una variabile Terraform spot_enabled permette di scegliere tra Spot e On-Demand, rendendo il progetto accessibile a tutti. Uno script Python, check_spot.py, regola automaticamente i prezzi in variables.tf per un’ottimizzazione continua.

4. Una pipeline CI/CD completa con GitLab

Una pipeline GitLab CI/CD (definita in gitlab-ci.yml) orchestra il deploy:

- Terraform: pianifica e applica le modifiche all’infrastruttura.

- Gestione delle istanze: avvia, arresta e verifica lo stato tramite SSM.

- Chiavi API: aggiunge o rimuove le chiavi in modo sicuro.

- Registrazioni: controlla gli accessi a LibreChat.

Lo script export.sh semplifica i comandi, sia in locale che via CI/CD, offrendo un’esperienza fluida e professionale.

5. Accessibilità globale grazie all’internazionalizzazione

Per raggiungere un pubblico mondiale, il README è tradotto in sei lingue (inglese, tedesco, spagnolo, giapponese, coreano, cinese) grazie al mio script di traduzione IA. Questo rende il progetto inclusivo e adatto a tutti gli utenti.

6. Sfide tecniche affrontate con successo

Adattare LibreChat 0.7.6 ha richiesto aggiustamenti precisi:

- Supporto Mistral: Aggiornamento di

librechat.yamlpermistral-large-latest. - Nginx: Correzione delle direttive SSL per HTTP/2.

- Spot/On-Demand: Gestione flessibile tramite Terraform.

Queste sfide sono state superate con test rigorosi e una documentazione dettagliata.

7. Perché questo progetto si distingue

Questo progetto si distingue per:

- Automazione completa: Tutto è scriptato, dall’infrastruttura all’installazione.

- Ottimizzazione: Costi ridotti e performance migliorate.

- Sicurezza: Gestione centralizzata e HTTPS di default.

- Accessibilità: Documentazione multilingue e opzioni semplici.

Riflette le mie competenze in architettura AWS, DevOps, cloud e scripting, oltre alla mia passione per l’open-source.

Scoprite e partecipate!

Esplorate questo progetto su GitLab, testatelo e condividete i vostri feedback. Che siate esperti o principianti, questo progetto è per voi. Contribuite per farlo crescere!

Contatto: contact@jls42.org

Su di me: Sono Julien LS, appassionato di architettura cloud AWS, DevOps, IA e automazione. Questo progetto si inserisce nella continuità dei miei lavori come BabelFish AI. Trovami su GitLab.

Questo documento è stato tradotto dalla versione fr alla lingua it utilizzando il modello gpt-5-mini. Per maggiori informazioni sul processo di traduzione, consultate https://gitlab.com/jls42/ai-powered-markdown-translator